Mit dem Textometer hat IMKIS ein neues Tool entwickelt, das die Verständlichkeit von Texten bewertet – in Schuljahren und fünf Stufen von sehr einfach bis sehr schwierig. Das Tool kann kostenlos auf unserer Website oder lokal auf dem eigenen PC verwendet werden.

Von Hannah Molderings

Ausprobieren können Sie den Textometer direkt unter diesem Artikel oder auf

textometer.de!

Möchte man die Verständlichkeit eines Textes überprüfen, kann man das unter anderem mit Verständlichkeits-Tools machen. Auf der Basis von mathematischen Formeln bewerten sie, wie (un)verständlich ein Text geschrieben ist. Der Vorteil dieser Tools: Ihre Ergebnisse sind objektiv und die Arbeit mit ihnen lässt sich ohne großen Aufwand in Arbeitsprozesse integrieren. Das hilft dabei, einen festgelegten Qualitätsstandard zu etablieren.

Bisher existierende Tools haben allerdings so ihre Schwachstellen. Manche sind nicht zuverlässig erreichbar, andere liefern unzuverlässige Verständlichkeitswerte und bei wieder anderen findet man das Eingabefeld vor lauter Werbung nicht.

Deshalb hat IMKIS in den letzten Monaten mithilfe Künstlicher Intelligenz ein eigenes Verständlichkeits-Tool entwickelt – den Textometer. Er liefert zuverlässig schlüssige Ergebnisse, ist intuitiv bedienbar und komplett werbefrei. Man kann sogar die Seite auf dem eigenen Rechner abspeichern und die Maschine lokal benutzen – das ist ein großer Vorteil für alle, die ihre Texte nicht im Internet eingeben wollen oder dürfen. Die Datenmenge des Downloads ist verschwindend gering, zuletzt lagen wir bei unter 50 Kilobyte!

Im Folgenden beantworten wir weitere wichtige Fragen:

Wie funktioniert der Textometer?

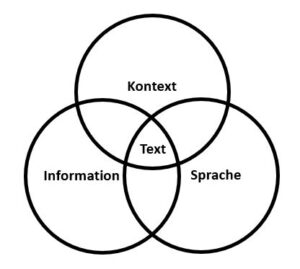

Der Textometer misst die Verständlichkeit von Texten auf der Basis einer Formel, die wir von IMKIS entwickelt haben. Ihr Ergebnis haben wir Brunn-Liffers-Index (BLIX) genannt. Die Formel selbst ähnelt klassischen Verständlichkeitsformeln, vereinfacht aber die Wortzählung (nur in Buchstaben) und bewertet lange Wörter erst ab einer Länge von 15 Buchstaben als schwer verständlich. Dieser Unterschied hat zur Folge, dass ein Text auch dann noch als einfach bewertet wird, wenn er unvermeidbar sperrige Wörter enthält. Die genaue Formel des BLIX ist kein Geheimnis – sie lautet: [Anzahl aller Wörter/Anzahl aller Sätze] + [Anzahl langer Wörter x 100/Anzahl aller Wörter]

Wie kommen die Einstufung nach Schuljahren und das beurteilte Verständlichkeitsniveau zustande?

In der Praxis hat es sich als sinnvoll erwiesen, den Benutzenden möglichst einfache Rückmeldungen zu ihren Texten zu geben. Der eine Wert, die Schuljahre, erleichtert die Zuordnung zu Niveaus aus dem realen Leben. Er gibt an, wie viele Schuljahre eine Person absolviert haben muss, damit sie den vorliegenden Text versteht. Der andere Wert, das Niveau in Worten, erleichtert es, sich selbst oder anderen Personen Zielvorgaben zu machen. Wir benutzen in unseren Seminaren sehr häufig eine der beiden Größen, um Texte besser zu machen. Zustande kommen die Rückmeldungen durch eine Einstufung nach dem gemessenen BLIX-Wert.

BLIX und Textometer insgesamt sind eine Gemeinschaftsentwicklung der beiden Germanisten Katrin Liffers und Stefan Brunn mit der Kognitionswissenschaftlerin Hannah Molderings und dem Datenjournalisten Sebastian Mondial.

Ausprobieren kann man den Textometer hier:

Wenn amerikanische Manager:innen sich von ihrem Stab für Entscheidungen informieren lassen, geschieht das oft nach dem gleichen Schema. Dahinter steht ein einfaches, aber sehr intelligentes Reflexions-Modell. Wir erklären, woher es stammt und wie es funktioniert.

Wenn amerikanische Manager:innen sich von ihrem Stab für Entscheidungen informieren lassen, geschieht das oft nach dem gleichen Schema. Dahinter steht ein einfaches, aber sehr intelligentes Reflexions-Modell. Wir erklären, woher es stammt und wie es funktioniert.